Rechnerarchitekturen

Der zentrale und wichtigste, zumeist auch der teuerste Teil eines

Computersystems ist die CPU (central processing unit).

Die wichtigsten Komponenten eines PC-Rechners werden in einem separaten

Abschnitt behandelt, ebenso moderne externe Bussysteme,

die nicht nur in PCs Verwendung finden.

Ein sanfter Übergang von der für PCs wichtigen 32-Bit-Architektur

hin zu 64 Bit wurde zunächst von der Firma AMD eingeleitet. Wenig später

brachte auch Intel eine auf 64 Bit erweiterte x86-Architektur,

die mit AMD weitgehend übereinstimmt, auf den Markt. Während der Entwicklung

nannte AMD die Architektur noch x86-64, kurz vor der Markteinführung der

Prozessoren änderte AMD allerdings die Bezeichnung in AMD64.

Neuerdings wird das Kürzel x64

vor allem von Microsoft für dieses erweiterte Programmiermodell verwendet.

Diese x64-Rechner sind in der Lage, die 16- und 32-Bit-Maschinenbefehle

älterer PC-Programme ohne Emulation auszuführen.

Auch im Linux-Bereich stehen Betriebssysteme mit 64-Bit-Unterstützung

bereit. Es wäre allerdings ein Fehler zu glauben, dass Prozessoren mit

interner 64-Bit-Architektur etwas Neues sind. Die Firma Digital Equipment hat

mit dem Alpha-Chip bereits 1992 eine 64-Bit-Architektur auf den Markt gebracht.

In der Zwischenzeit wurde Digital von Compaq und Compaq von Hewlett Packard

übernommen, sodass die Alpha-Technologie jetzt in Händen von HP ist.

Das jeweils oberste Ende des Leistungsspektrums bleibt den Supercomputern

vorbehalten.

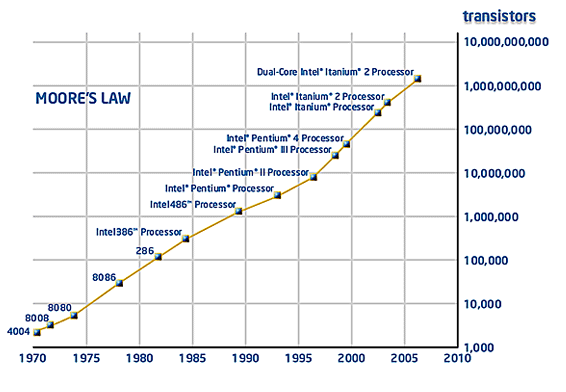

Die

Entwicklung von Rechnerhardware ist von einer interessanten Gesetzmäßigkeit

gekennzeichnet, die von Gordon Moore bereits im Jahr 1965 aufgestellt wurde:

Moore behauptete in einer mittlerweile berühmten Veröffentlichung,

dass die Anzahl der Transistoren auf einem intergrierten Schaltkreis bis zum

Jahr 1975 exponentiell wachsen würde. Seine Prognose traf nicht nur für

den Zeitraum von zehn Jahren zu sondern war bis etwa 2013 gültig. Seit

vielen Jahren wird diese Entwicklung als Moore's Law

bezeichnet.

Die

Entwicklung von Rechnerhardware ist von einer interessanten Gesetzmäßigkeit

gekennzeichnet, die von Gordon Moore bereits im Jahr 1965 aufgestellt wurde:

Moore behauptete in einer mittlerweile berühmten Veröffentlichung,

dass die Anzahl der Transistoren auf einem intergrierten Schaltkreis bis zum

Jahr 1975 exponentiell wachsen würde. Seine Prognose traf nicht nur für

den Zeitraum von zehn Jahren zu sondern war bis etwa 2013 gültig. Seit

vielen Jahren wird diese Entwicklung als Moore's Law

bezeichnet.

Gordon Moore war übrigens einer der Gründer der Firma

Intel im Jahr 1968.

Die folgende Abbildung (entnommen aus http://www.intel.com/technology/mooreslaw/)

zeigt die Gültigkeit von Moore's Law anhand der Transistorzahl von Intel-Prozessoren

über einen Zeitraum von fast 40 Jahren.

Man beachte bei dem Diagramm die logarithmische Skalierung der

Ordinatenachse.

Andere "Gesetzmäßigkeiten" aus dem Bereich

der Computerhardware:

| Parkinson's Law of Data |

| "Data expands to fill the space

available for storage." |

| Der Kauf von mehr Speicher (Memory) fördert die Verwendung

von speicherintensiven Techniken. Seit der Mitte der Achtziger-Jahre verdoppelt

sich die Speicherverwendung ungefähr alle 18 Monate. Glücklicherweise

verdoppelt sich auch die Speicherdichte, die man für das gleiche

Geld kaufen kann, etwa alle 18 Monate (siehe Moore's Law). Unglücklicherweise

garantieren die Gesetze der Physik, dass sich Letzteres nicht ewig fortsetzen

wird. |

| Gates's Law |

| "The speed of software halves every

18 months." |

|

Diese oft zitierte Gesetzmäßigkeit bezieht

sich in ironischer Weise auf die Tendenz von Software, sich aufzublasen

und die Verdopplung der Hardwarekapazitäten (siehe Moore's Law)

innerhalb von 18 Monaten aufzufressen. Das Gesetz bezieht sich auf Bill

Gates; Microsoft wird weithin als die Stelle angesehen, wo sich Programme

am meisten im Lauf der Zeit aufblähen.

|

Die

Entwicklung von Rechnerhardware ist von einer interessanten Gesetzmäßigkeit

gekennzeichnet, die von Gordon Moore bereits im Jahr 1965 aufgestellt wurde:

Moore behauptete in einer mittlerweile berühmten Veröffentlichung,

dass die Anzahl der Transistoren auf einem intergrierten Schaltkreis bis zum

Jahr 1975 exponentiell wachsen würde. Seine Prognose traf nicht nur für

den Zeitraum von zehn Jahren zu sondern war bis etwa 2013 gültig. Seit

vielen Jahren wird diese Entwicklung als Moore's Law

bezeichnet.

Die

Entwicklung von Rechnerhardware ist von einer interessanten Gesetzmäßigkeit

gekennzeichnet, die von Gordon Moore bereits im Jahr 1965 aufgestellt wurde:

Moore behauptete in einer mittlerweile berühmten Veröffentlichung,

dass die Anzahl der Transistoren auf einem intergrierten Schaltkreis bis zum

Jahr 1975 exponentiell wachsen würde. Seine Prognose traf nicht nur für

den Zeitraum von zehn Jahren zu sondern war bis etwa 2013 gültig. Seit

vielen Jahren wird diese Entwicklung als Moore's Law

bezeichnet.